A medida que las organizaciones diseñan para el futuro y aumentan las cargas de trabajo computacionales en Google Cloud, es crucial comprender las opciones disponibles. Google Cloud ofrece una variedad de servicios de cómputo diseñados para cubrir distintas necesidades. A continuación, exploramos cada uno de estos servicios y sus características principales.

Compute

Compute Engine es la oferta de infraestructura como servicio (IaaS) de Google Cloud. Este servicio proporciona recursos de cómputo, almacenamiento y red que funcionan de manera similar a los centros de datos físicos.

Características

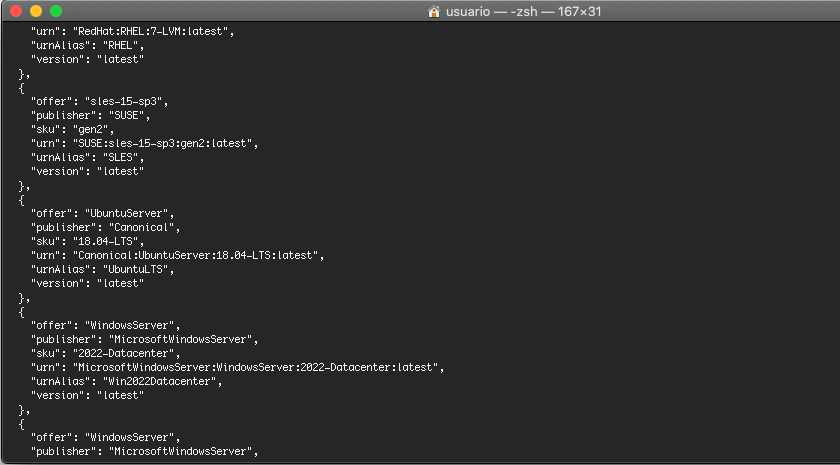

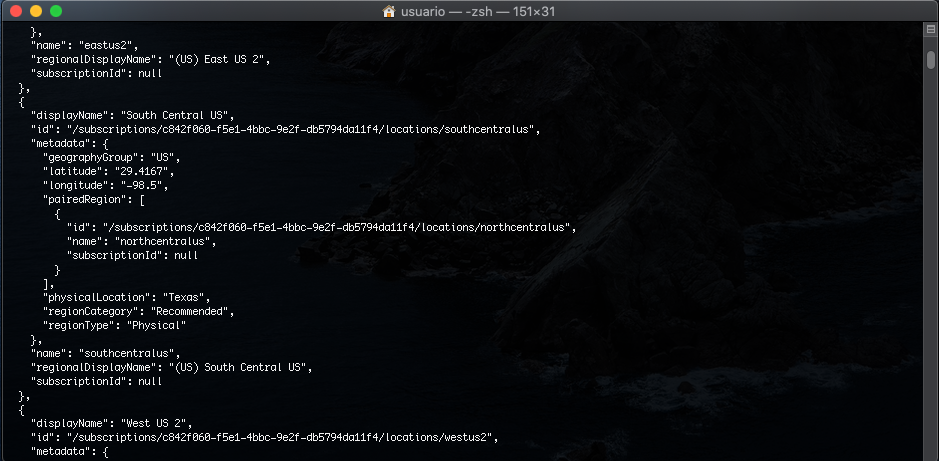

- Acceso a configuraciones predefinidas y personalizadas de máquinas virtuales (VMs).

- Soporte para VMs de gran tamaño (hasta 416 vCPUs y más de 12 TB de memoria).

- Almacenamiento mediante discos persistentes (hasta 257 TB con snapshots para copias de seguridad) y SSD locales (para operaciones de alta velocidad).

- Balanceadores de carga globales con capacidad de escalado automático mediante grupos de instancias gestionadas.

- Facturación por segundo para optimizar costos, especialmente en trabajos de procesamiento por lotes.

- VMs preemtibles para cargas de trabajo tolerantes a interrupciones, con costos significativamente más bajos.

Ventajas:

- Control total sobre la infraestructura, con personalización de sistemas operativos.

- Ideal para aplicaciones que combinan sistemas operativos diversos o migraciones de cargas de trabajo locales (lift-and-shift).

Google Kubernetes Engine (GKE) permite ejecutar aplicaciones en contenedores dentro de un entorno de nube.

Características

- Basado en Kubernetes, permite empaquetar código junto con sus dependencias en contenedores.

- Ideal para aplicaciones modernas que requieren escalabilidad dinámica y automatización.

- Soporte completo para la orquestación y gestión de contenedores en un entorno controlado.

Ventajas:

- Escalabilidad y flexibilidad para aplicaciones en contenedores.

- Integración nativa con el ecosistema de Google Cloud.

”App

App Engine es una plataforma completamente gestionada que permite a los desarrolladores enfocarse en escribir código sin preocuparse por la infraestructura.

”Características

- Soporte para lenguajes populares como Java, Python, PHP, Go, Node.js, Ruby, C#, entre otros.

- Implementación automática de infraestructura necesaria para ejecutar aplicaciones.

- Integración con herramientas como Cloud Monitoring, Cloud Logging y Error Reporting.

- Soporte para control de versiones y división de tráfico.

”Ventajas:”

- Sitios web, backends para aplicaciones móviles y videojuegos.

- Creación de APIs RESTful con facilidad.

”Cloud

Cloud Functions es una solución ligera basada en eventos para ejecutar funciones pequeñas con propósitos específicos.

”Características

- Ejecución de código en respuesta a eventos, como la carga de un archivo en Cloud Storage.

- Totalmente serverless, elimina la necesidad de gestionar servidores.

- Soporte para lenguajes como Node.js, Python, Go, Java, .Net Core, Ruby, y PHP.

”Ventajas:”

- Facturación precisa por milisegundos de ejecución.

- Nivel gratuito perpetuo para muchos casos de uso.

- Ideal para arquitecturas de microservicios, backend para móviles o IoT, y análisis en tiempo real.

”Cloud

Cloud Run es una plataforma gestionada que ejecuta contenedores sin estado en respuesta a solicitudes web o eventos de Pub/Sub (Publicación/Suscripción).

”Características

- Basado en Knative, ofrece portabilidad entre entornos y plataformas.

- Escala automáticamente de cero a miles de solicitudes casi instantáneamente.

- Facturación basada en el uso, calculada por cada 100 milisegundos.

”Ventajas:”

- Enfoque completamente serverless, elimina la gestión de infraestructura.

- Compatible con cualquier entorno que soporte Knative.

- Ideal para aplicaciones ligeras que requieren escalado rápido y eficiente.

честные казино с быстрыми выплатами

бездепозитные бонусы казино

играть в лучшем казино на деньги

база казино с бездепозитным бонусом

онлайн казино России

casino oyunu

”Resumen”

Cada servicio de cómputo en Google Cloud está diseñado para abordar necesidades específicas:

- Compute Engine: Ideal para cargas de trabajo personalizadas y migraciones lift-and-shift.

- GKE: La mejor opción para aplicaciones en contenedores que requieren alta escalabilidad.

- App Engine: Perfecto para desarrolladores que desean enfocarse en el código y no en la infraestructura.

- Cloud Functions: Excelente para tareas basadas en eventos o microservicios.

- Cloud Run: Para contenedores sin estado que necesitan escalado rápido y eficiente.