El Big Data y la Inteligencia Artificial (IA) han emergido como poderosas herramientas que transforman la forma en que vivimos y trabajamos. Sin embargo, detrás de la fachada de la innovación y la eficiencia, se esconde una creciente preocupación: ¿están estas tecnologías contribuyendo a aumentar la desigualdad y representan alguna amenaza para nuestras vidas?

Desigualdad en la Toma de Decisiones

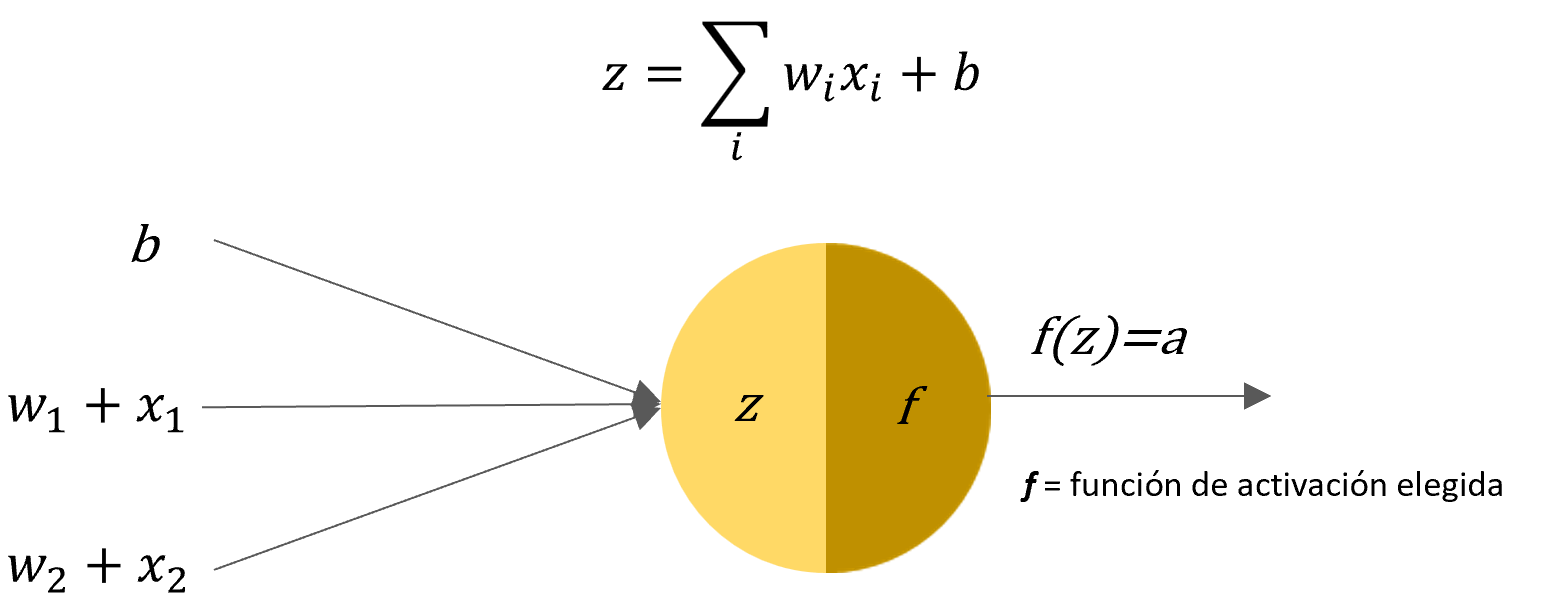

La aplicación de algoritmos basados en Big Data para la toma de decisiones en áreas cruciales como préstamos, educación y empleo ha suscitado inquietudes. Las decisiones automatizadas a menudo se basan en patrones históricos, lo que puede perpetuar y amplificar desigualdades existentes. La asignación de recursos, oportunidades y beneficios puede estar sesgada, afectando desproporcionadamente a comunidades marginadas.

Riesgos de Discriminación

La opacidad y falta de regulación en torno a estos algoritmos pueden resultar en discriminación inadvertida. Desde la denegación de préstamos hasta la exclusión de oportunidades educativas, las personas pueden enfrentarse a consecuencias negativas simplemente debido a factores como su código postal o historial crediticio. Esto crea una brecha significativa entre los beneficiados y los perjudicados.

La Amenaza de las “Armas de Destrucción Matemática”

El término “Weapons of Math Destruction” (Armas de Destrucción Matemática), acuñado por Cathy O’Neil, destaca cómo estos algoritmos, aparentemente objetivos, pueden tener consecuencias devastadoras. La falta de transparencia y la dificultad para impugnar decisiones algorítmicas plantean riesgos significativos para la privacidad y la equidad, erosionando la confianza en estas tecnologías.

Habla sobre varios casos en donde las personas se han visto perjudicadas por las decisiones de los algoritmos y como la imparcialidad de estos afecta a las personas.

Te invito a que le eches un vistazo:

- Ingles: Weapons of Math Destruction

- Español: Armas de Destrucción Matemática

Impacto en la Democracia

El uso indiscriminado de Big Data y IA también plantea riesgos para la democracia. La manipulación de la información y la segmentación de audiencia en campañas políticas pueden distorsionar la percepción pública y afectar la toma de decisiones informada.

No olvidemos el caso de Cambridge Analytica, que presumió de poseer 5.000 datos sobre cada votante estadounidense, alegando la capacidad de determinar la personalidad de cada individuo. Utilizando principalmente Facebook como fuente principal de información, la compañía obtuvo de manera indebida datos de hasta 87 millones de perfiles, incluyendo actualizaciones de estado, indicaciones de “me gusta” y mensajes privados. Estos datos fueron utilizados para dirigir mensajes individualizados con el objetivo de influir en el comportamiento de los votantes.

¿Cómo Abordamos Estos Desafíos?

Es crucial abordar estos problemas desde diversas perspectivas. La regulación efectiva, la transparencia en los algoritmos, y la incorporación de ética en el desarrollo de tecnologías son pasos fundamentales. Además, la participación activa de la sociedad civil y la conciencia pública pueden ser catalizadores para un cambio positivo.

Mientras celebramos los avances tecnológicos, no podemos ignorar las sombras que acompañan al Big Data y la Inteligencia Artificial. Es nuestra responsabilidad colectiva asegurarnos de que estas herramientas se utilicen para construir un futuro más equitativo y sostenible, en lugar de contribuir a la desigualdad y amenazar nuestras vidas.