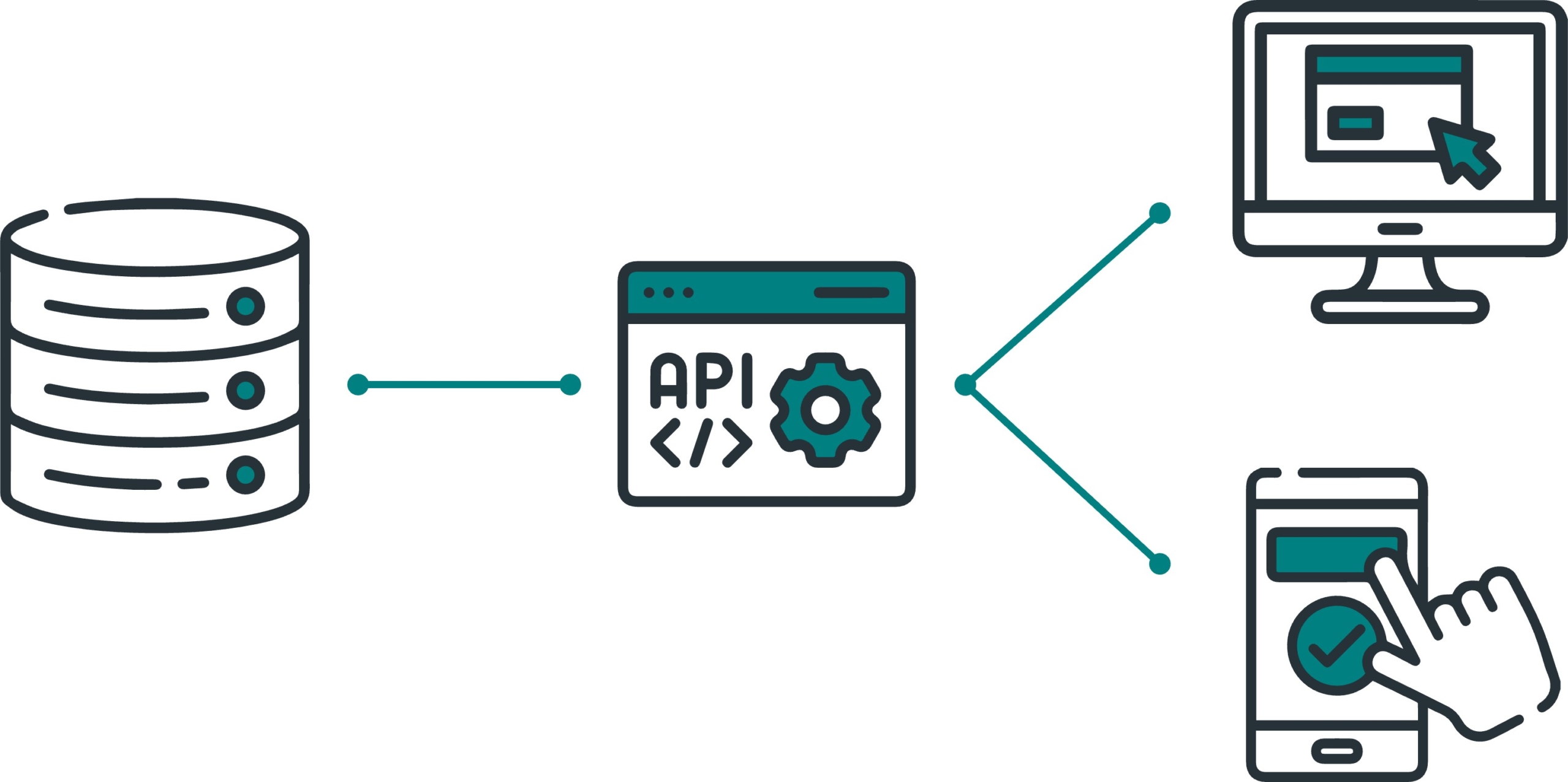

Interesado en las APIs(Interfaces de Programación de Aplicaciones), exploremos que es y además te dejo una lista de APIs públicas que puedes utilizar para realizar pruebas de desarrollo.

¿Qué es una API?

Antes de sumergirnos en el cómo, hablemos sobre el qué. Una API es esencialmente un conjunto de reglas que permite que diferentes aplicaciones se comuniquen entre sí. En términos más simples, actúa como un puente que permite que tu aplicación solicite y comparta datos con otra; para establecer esta comunicación se trabaja con un lenguaje común, actualmente la mayoría de APIs trabajan con JSON.

- JSONPlaceholder: Una API de prueba que simula una API RESTful y proporciona datos ficticios como usuarios, publicaciones y comentarios.

- OpenWeatherMap: Ofrece datos meteorológicos en tiempo real y pronósticos, perfecto para aplicaciones relacionadas con el clima.

- REST Countries: Proporciona información detallada sobre países, incluyendo nombres, banderas y datos geográficos.

- PokeAPI: Ideal para los amantes de Pokémon, esta API proporciona datos detallados sobre Pokémon, movimientos y tipos.

- SpaceX API: Ofrece información sobre lanzamientos, cohetes, cápsulas y más relacionado con SpaceX.

- Random User Generator: Genera usuarios aleatorios con detalles como nombres, direcciones y fotos de perfil.

- Random API: Genera productos aleatorios.

- JokeAPI: Para agregar un toque de humor a tus aplicaciones, esta API proporciona chistes en diferentes categorías.

- The Cat API: Si te encantan los gatos, esta API ofrece imágenes de gatos adorables.

- Dog CEO’s Dog API: Similar a la anterior, pero con imágenes de perros encantadores.

- The World Bank: Ofrece series temporales y metadatos relacionados con Indicadores del banco mundial. Tiene la particularidad que trabaja con XML.

Recuerda revisar la documentación de cada API para entender cómo realizar solicitudes y qué datos puedes obtener. ¡Diviértete explorando y probando en tu desarrollo! 🚀🌐