La arquitectura de microservicios ha emergido como una piedra angular para muchas empresas en todo el mundo. Este enfoque revolucionario ha transformado la manera en que concebimos y construimos aplicaciones, permitiendo una mayor flexibilidad y escalabilidad. En este artículo, exploraremos a fondo qué es exactamente la arquitectura de microservicios y cómo ha llegado a ser la elección predeterminada para el desarrollo de software en numerosas compañías.

¿Qué es un Microservicio?

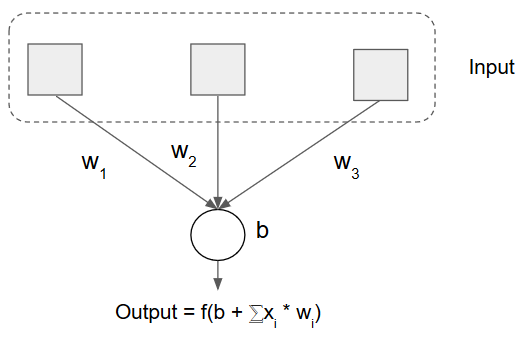

El término servicio se refiere a un conjunto de funciones o tareas que un programa o aplicación proporciona para cumplir con una o varias funciones específicas. Estos servicios son a menudo parte de una arquitectura más amplia y se diseñan para realizar tareas específicas de manera eficiente y modular. Aquí hay algunas características clave de los servicios en programación:

-

Funcionalidad específica: Un servicio generalmente se centra en una funcionalidad específica o conjunto de funciones relacionadas. Por ejemplo, un servicio puede encargarse de gestionar la autenticación de usuarios, procesar pagos, o proporcionar acceso a bases de datos.

-

Interfaz definida: Los servicios suelen tener una interfaz claramente definida que especifica cómo se pueden acceder y utilizar. Esto se puede lograr mediante API (Interfaz de Programación de Aplicaciones) o mediante protocolos de comunicación específicos.

-

Independencia: Los servicios son diseñados para ser independientes y modularizados. Esto significa que pueden ser desarrollados, probados y actualizados de manera independiente, lo que facilita la gestión y mantenimiento del sistema completo.

-

Comunicación: Los servicios a menudo se comunican entre sí o con otras partes del sistema. La comunicación puede ocurrir a través de diversos mecanismos, como llamadas a API, mensajes, o servicios web.

-

Reusabilidad: Dado que los servicios están diseñados para realizar funciones específicas, pueden ser reutilizados en diferentes partes de una aplicación o incluso en diferentes aplicaciones. Esto promueve la eficiencia en el desarrollo y la mantenibilidad del código.

-

Escalabilidad: La arquitectura basada en servicios facilita la escalabilidad de una aplicación, ya que los servicios pueden ser escalados de manera independiente según las necesidades de carga de trabajo específicas.

-

Tecnologías: Los servicios pueden implementarse utilizando diversas tecnologías, como microservicios, servicios web, funciones en la nube, entre otros, dependiendo de los requisitos del proyecto.

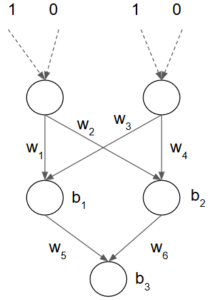

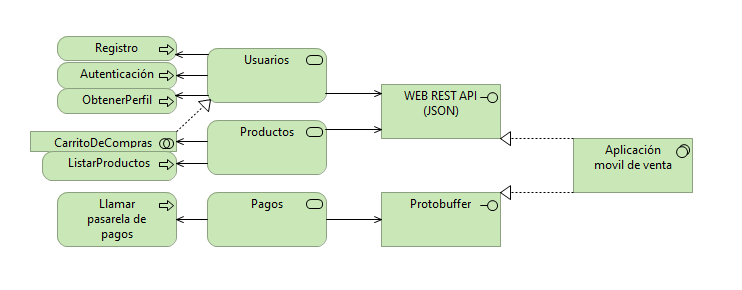

Ahora, si hablamos específicamente de microservicios estamos hablando de un servicio aun mas especializado, es decir que al momento de planificar nuestra arquitectura debemos procurar identificar los procesos para generar sus abstracciones de manera clara pero simple; pongamos un ejemplo para entenderlo mejor: Podemos tener un servicio que se encargue de la gestión de usuarios, en donde tenemos procesos como registro, autenticación, obtener perfil y actualizar datos, ahora esto se podría separar en dos microservicios, por una parte podríamos tener un microservicio encargado de lo que tiene que ver con el registro y autenticación y el otro de los datos de sesión o perfil; claro que esto no es así tan fácil, esto requiere un análisis concienzudo, entender los procesos y que encaje con nuestra arquitectura empresarial. Cualquier servicio puede ser tratado como microservicio siempre y cuando tenga cohesión lógica y estructural.

¿Qué es una arquitectura de Microservicios?

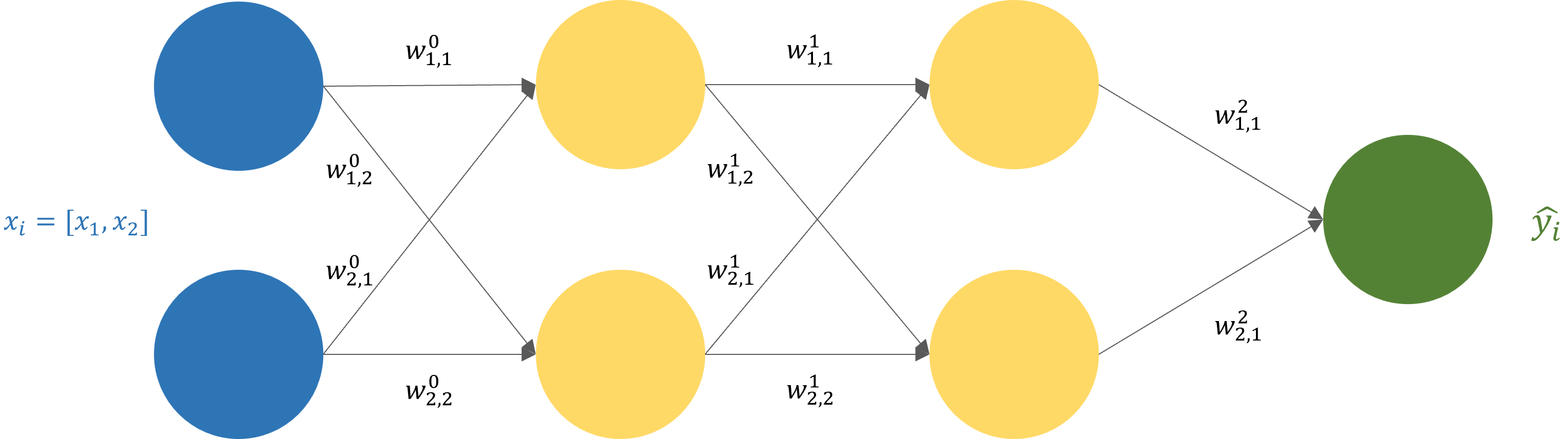

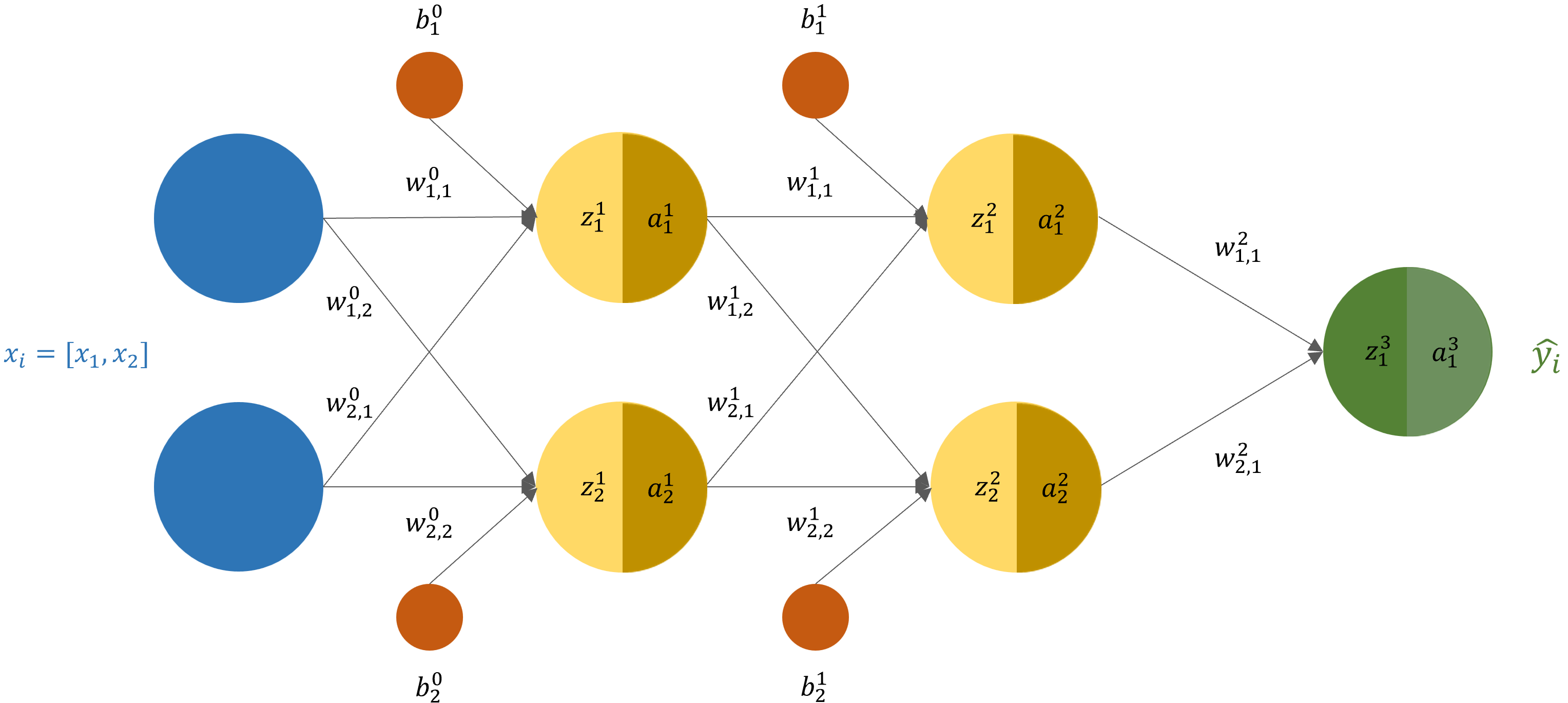

Muy fácil, es un enfoque de diseño de software que organiza una aplicación como un conjunto de servicios pequeños e independientes. Cada servicio se centra en una tarea específica y puede ser desarrollado, implementado y escalado de manera independiente. Estos servicios se comunican entre sí a través de interfaces bien definidas.

Aquí hay algunas características clave de la arquitectura de microservicios:

-

Descomposición en servicios: En lugar de construir una aplicación monolítica, la arquitectura de microservicios divide la funcionalidad en servicios más pequeños, cada uno ejecutando un proceso independiente. Cada servicio se enfoca en realizar una tarea específica dentro del dominio de la aplicación.

-

Independencia y escalabilidad: Cada servicio es independiente y puede ser desarrollado, implementado y escalado de manera autónoma. Esto permite a los equipos de desarrollo trabajar de manera más eficiente y facilita la escalabilidad, ya que solo los servicios que necesitan más recursos pueden ser escalados.

-

Comunicación a través de APIs: Los microservicios se comunican entre sí a través de APIs bien definidas. Esto significa que cada servicio expone una interfaz clara que especifica cómo otros servicios pueden interactuar con él. La comunicación puede realizarse de manera síncrona o asíncrona, según los requisitos.

-

Despliegue independiente: Los microservicios pueden ser desplegados de forma independiente, lo que facilita la implementación continua y la actualización de servicios sin afectar toda la aplicación. Esto mejora la agilidad del desarrollo y reduce el tiempo de inactividad.

-

Resiliencia y tolerancia a fallos: La arquitectura de microservicios fomenta la resiliencia al diseñar servicios que son autónomos y pueden manejar fallas de manera aislada. Si un servicio falla, no debería afectar a los demás servicios en la aplicación.

-

Poliglota: Cada servicio puede ser desarrollado en el lenguaje de programación más adecuado para su tarea específica. Esto permite a los equipos utilizar las tecnologías más apropiadas para cada servicio, según sus necesidades.

-

Gestión de datos descentralizada: Cada servicio puede tener su propia base de datos, y la gestión de datos se realiza de manera descentralizada. Esto evita la dependencia de una única base de datos monolítica.

-

Orientación al dominio de negocio: Los microservicios se organizan en torno a las capacidades del negocio, lo que facilita la comprensión y mantenimiento del sistema. Sobre como entender y trabajar el dominio del negocio te deje unos post de arquitectura empresarial.

Las empresas a nivel mundial han adoptado tan ampliamente el modelo de arquitectura de microservicios que casi se ha convertido en la forma estándar de desarrollo de software. Estas compañías cuentan con decenas, cientos e incluso miles de microservicios a su disposición.

En pocas palabras, la arquitectura de microservicios organiza una aplicación como una colección de servicios, llamados microservicios, cada uno de los cuales es responsable de una parte específica de la lógica de la aplicación, generalmente definida por una capacidad comercial particular.

Tomemos como ejemplo una aplicación de mercado en línea. La aplicación puede tener múltiples funciones, como búsqueda, carrito de compras, pagos, historial de pedidos y muchas más. Cada función puede ser tan diferente que el código puede (y en algunos casos, debería) ser completamente independiente del resto de la aplicación. En este ejemplo, la búsqueda y los pagos técnicamente no tienen nada en común. En el modelo de arquitectura de microservicios, cada componente sería un servicio independiente que desempeña su propio papel en el sistema.

Desafíos… Separar la Aplicación en Servicios:

Organizar cada parte de la aplicación como un servicio separado no es necesariamente un requisito. Al igual que con cualquier modelo de arquitectura o aspecto del desarrollo de software, los ingenieros deben ser cuidadosos al elegir un enfoque o solución particular, realizando un análisis inicial y comprendiendo la solución en las condiciones dadas.

El dilema monolítico

Para entender la motivación detrás de la arquitectura de microservicios, primero, veamos el enfoque opuesto: las aplicaciones monolíticas o “monolitos”. Estas aplicaciones son construidas y ejecutadas como un solo programa, con una arquitectura simple que no implica dividir la aplicación en partes independientes.

Ventajas de los Monolitos:

-

Código Compacto: Al no dividir la aplicación, el código base es más pequeño, evitando complejidades asociadas a la comunicación entre componentes.

-

Flexibilidad en la Lógica de la Aplicación: Permite cambios estructurales o lógicos fácilmente en las etapas iniciales de desarrollo, donde la agilidad es clave.

-

Alcance Reducido: No todos los servicios necesitan descomposición; servicios simples pueden permanecer integrales.

¿Cuándo los monolitos se vuelven problemáticos?

-

Tamaño y Despliegues Lentos: A medida que la aplicación crece, el tiempo de construcción, inicio y despliegue puede volverse excesivamente lento.

-

Imposibilidad de desplegar partes independientemente: La incapacidad de actualizar partes específicas puede ralentizar el desarrollo y lanzamiento.

-

Amplitud de impacto: Errores en una función afectan toda la aplicación, generando posibles problemas significativos.

-

Cuello de botella en escalabilidad vertical: A medida que la aplicación crece, es difícil escalarla aún más debido a limitaciones en CPU y RAM.

La arquitectura de microservicios surge cuando los monolitos se vuelven demasiado grandes. Los desarrolladores enfrentan problemas como tamaños de aplicación masivos, despliegues lentos y dependencias no deseadas entre componentes. Aquí es donde entran los microservicios.

En el siguiente post, exploraremos cómo la división de la aplicación en microservicios aborda estos problemas y qué aspectos debes tener en cuenta. ¡Mantente atento para descubrir cómo esta arquitectura puede revolucionar tu enfoque de desarrollo! No olvide dejar tus comentarios e inquietudes. Hasta la próxima.