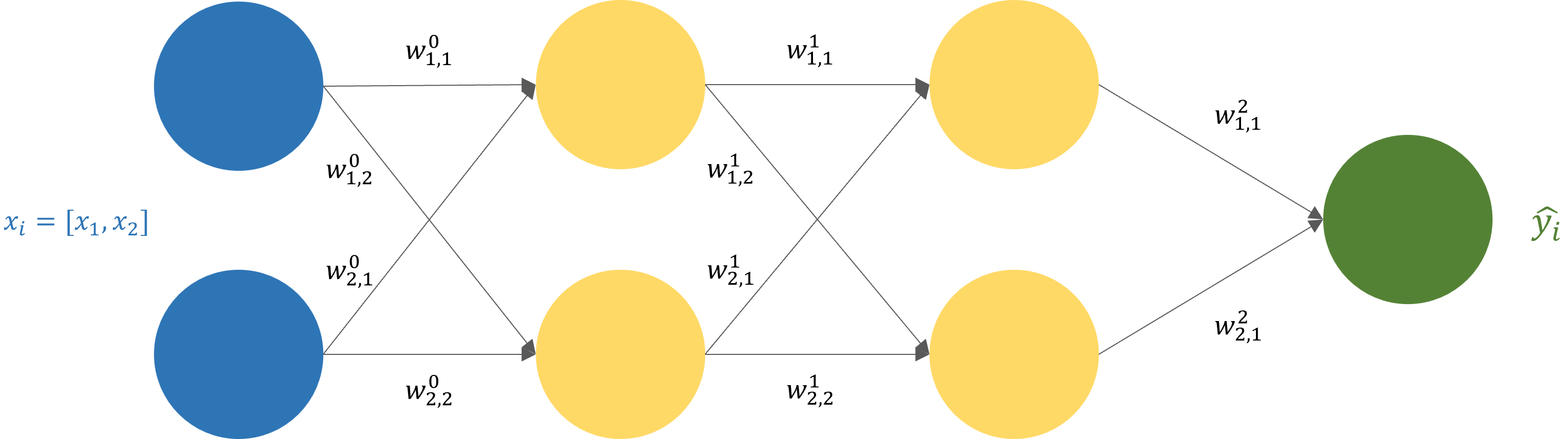

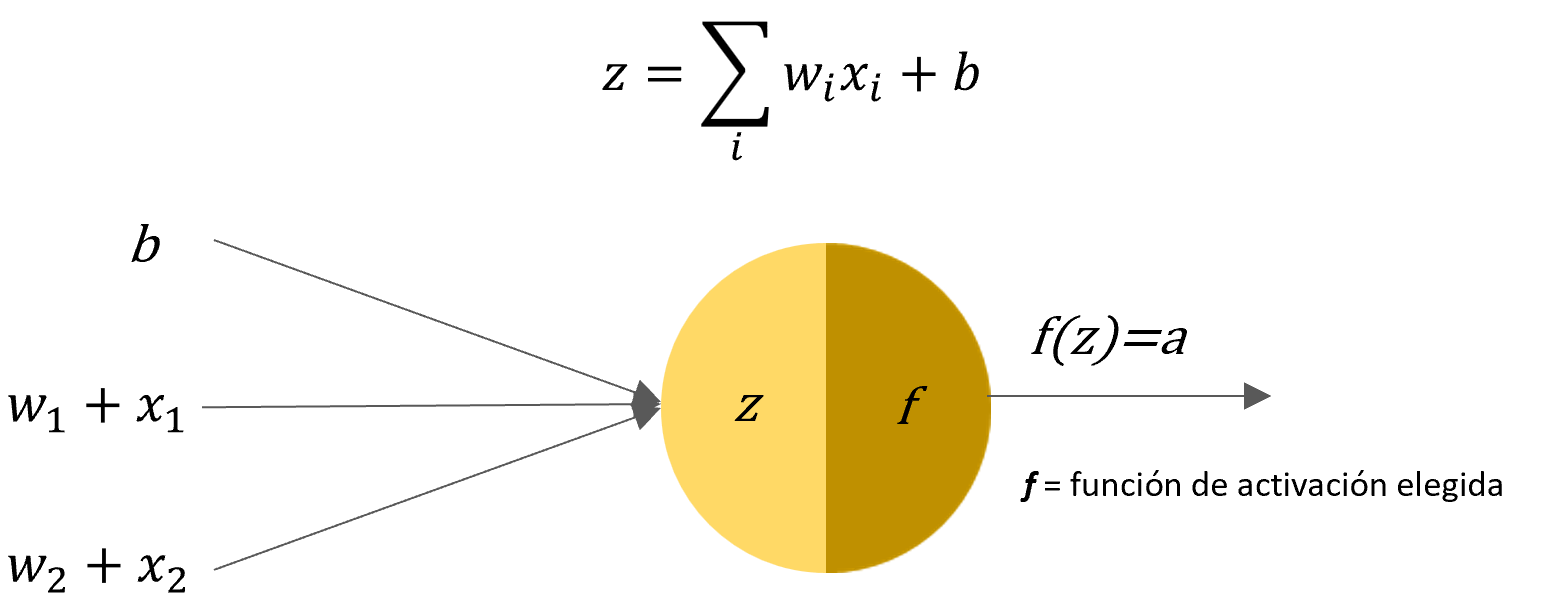

Los modelos fundacionales, también conocidos como modelos de IA de propósito general o sistemas de inteligencia artificial a gran escala, representan un avance significativo en el campo de la inteligencia artificial. Son modelos de aprendizaje automático entrenados en conjuntos de datos masivos y no etiquetados, lo que les permite realizar una amplia gama de tareas sin necesidad de ser ajustados o entrenados de forma específica para cada una de ellas.

Los modelos fundacionales aún se encuentran en sus primeras etapas de desarrollo, pero ya tienen un impacto significativo en diversos sectores. Su capacidad para realizar múltiples tareas y adaptarse a diferentes dominios los convierte en una herramienta poderosa con un gran potencial para el futuro de la inteligencia artificial.

Beneficios y diferencias de los modelos fundacionales frente a los modelos normales de IA

Beneficios

- Capacidad multitarea: Los modelos fundacionales pueden realizar diversas tareas, mientras que los modelos normales de IA generalmente están diseñados para una sola tarea específica.

- Eficiencia: Se entrenan en conjuntos de datos masivos sin necesidad de etiquetarlos manualmente, lo que reduce el tiempo y el esfuerzo necesarios para su desarrollo.

- Adaptabilidad: Se pueden ajustar a nuevas tareas y dominios específicos con un entrenamiento adicional relativamente ligero.

- Potencial de innovación: Permiten la creación de nuevos productos y servicios gracias a su capacidad para generar contenido creativo y soluciones innovadoras.

Diferencias

- Tamaño y complejidad: Los modelos fundacionales son mucho más grandes y complejos que los modelos normales de IA, lo que requiere mayor potencia computacional para su entrenamiento y ejecución.

- Interpretabilidad: Es más difícil comprender las decisiones tomadas por los modelos fundacionales debido a su complejidad.

- Sesgos y riesgos: Los modelos fundacionales pueden heredar sesgos presentes en los datos con los que se entrenan, además de presentar riesgos potenciales de uso indebido o manipulación.

| Característica | Modelo fundacional | Modelo normal de IA |

|---|---|---|

| Capacidad multitarea | Alta | Baja |

| Eficiencia | Alta | Baja |

| Adaptabilidad | Alta | Baja |

| Tamaño y complejidad | Alto | Bajo |

| Interpretabilidad | Baja | Alta |

| Sesgos y riesgos | Alto | Bajo |

Pese a todas las ventajas que presentan los modelos fundacionales, un modelo estándar(especializado) es lo mas accesible para las empresas y emprendedores que se introducen a este mundo, además de que da un mejor control sobre el producto que construyen. Sin embargo los modelos fundacionales aportan muchas ideas y características que los hacen muy útiles para el uso diario.

Algunos ejemplos de modelos fundacionales son:

- El conocido GPT4 de OpenIA.

- El nuevo Gemini de Google, del cual hicimos un post.

- Megatron-Turing NLG de NVIDIA.

- WuDao 2.0 de la Academia de Ciencias de China.

Déjanos tus dudas y comentarios. Comparte y nos vemos en el próximo post.