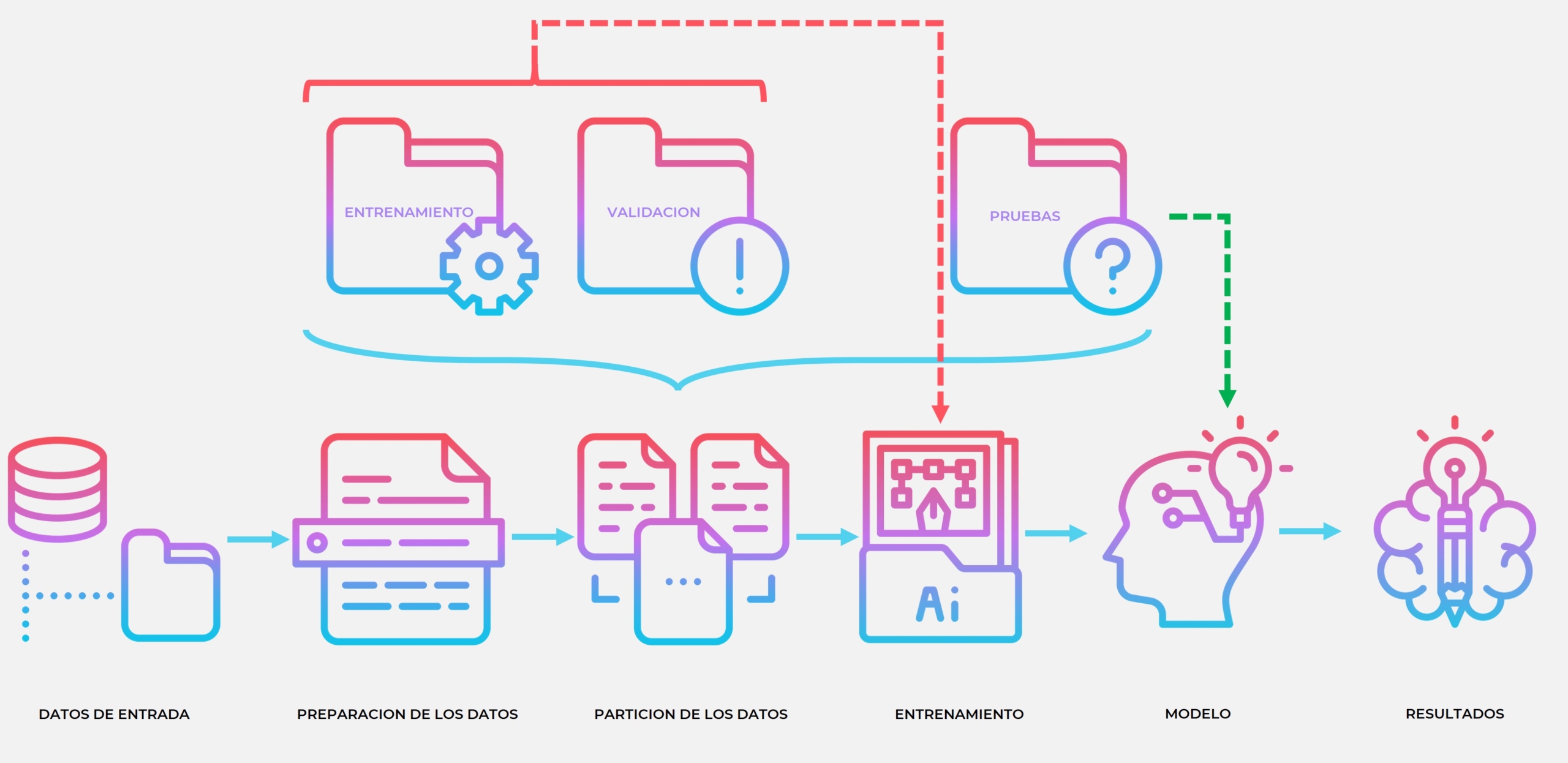

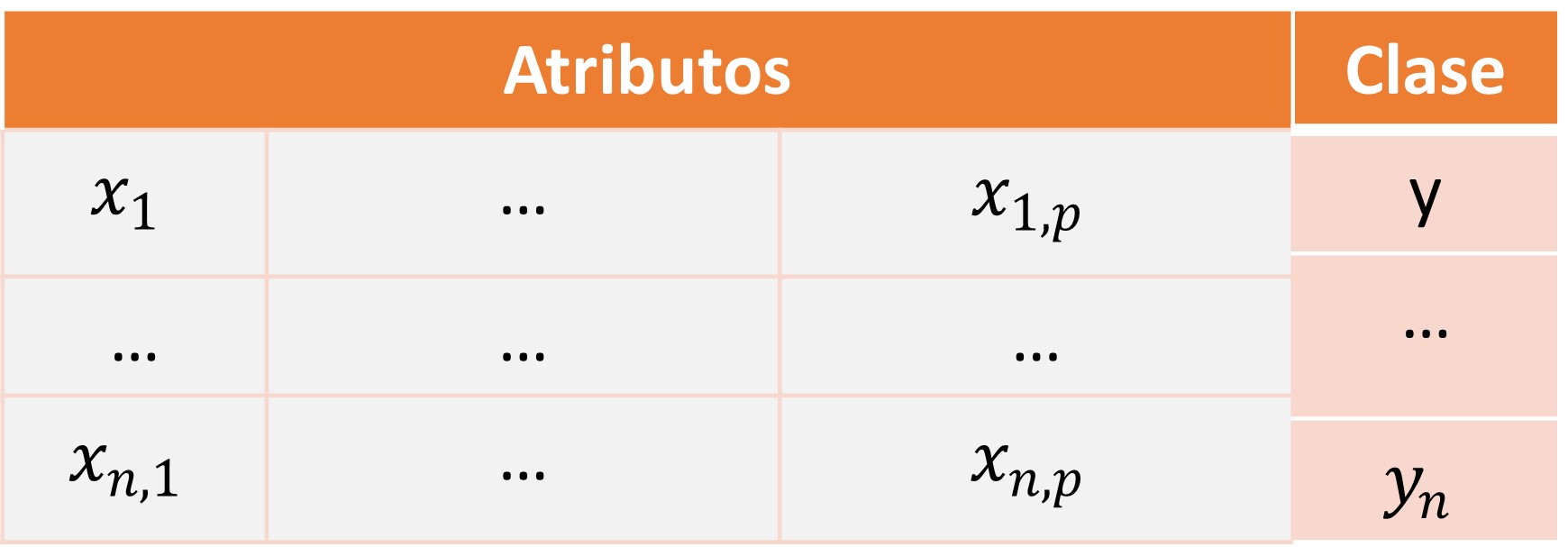

Teniendo en cuenta la premisa anterior debemos considerar que la inteligencia humana esta llena de incertidumbre e imprecisión, justamente la curiosidad es el mayor motor para el avance científico y es producto de un camino que recorremos hace miles de años, un proceso evolutivo y mental que queremos concluir por ejemplo en una teoría del todo, o en deserciones filosóficas para tratar de tener control y superar a la misma muerte (Si tiene curiosidad de por que digo esto vea este libro: Política para Amador). El punto del asunto es preguntarnos que tan relevante debería ser la incertidumbre en nuestros algoritmos; por eso se celebra un congreso para crear sistemas híbridos, dejando en claro que la inteligencia artificial no lo resuelve todo y que se necesita un acercamiento humano para entender y contextualizar los problemas; estamos acostumbrados a obtener grandes cantidades de datos y luego por medio de procesos estadísticos o métodos de inteligencia artificial inferir resultados y estimar predicciones, pero en estos procesos no se tiene en cuenta los sesgos humanos, coloquemos un ejemplo mas claro: imaginemos que se realiza una encuesta a diferentes poblaciones para determinar el nivel de felicidad, esto es muy subjetivo tanto para los encuestados como para los encuestadores, ya que los encuestadores por mas imparciales que pretendan ser interpretaran los datos a su propio contexto y por ejemplo no se tiene en cuenta la propia conducta y pensamiento humano; ahora podríamos decir que es por que nos falta variables, pero en si es imposible obtenerlas todas y ya veremos el por que.

El universo en si es un sistema caótico, por mas modelos o representaciones que hagamos de el simplemente no alcanzamos a modelar la realidad, para poder predecir algo con suma certeza deberíamos tomar todo nuestro universo y descomponerlo en variables, crear una simulación completa del todo, lo cual es imposible ya que ni siquiera conocemos la totalidad del universo y avanzamos poco a poco pero parece que nunca alcanzaremos datos totalmente certeros; y es que esta es la magia de los sistemas caóticos, podemos medir tanto como queramos, aproximarnos a cantidades de errores infinitesimales y aun así no obtendremos la cantidad exacta, vivimos en la paradoja de Zenón.

A pesar del caos muchas de nuestras mediciones y predicciones podemos hacerlas a partir de un contexto local, dándonos resultados muy buenos, este tipo de aproximaciones las trabajamos con la lógica difusa, que justamente considera las relaciones entre las variables de un contexto. Recuerdo un anécdota muy curioso de cuando la Nasa estrelló una sonda por una mala comunicación entre los ingenieros, esto demuestra que no solo es tomar datos y asumir que es suficiente, se debe hacer un análisis humano, a conciencia, previniendo y teniendo en cuenta nuestros sesgos y contextos.

Las principales causas de incertidumbre son:

- Insuficiente experiencia

- Inadecuada representación del conocimiento

- Información poco fiable

- No completitud

- Inexactitud inherente al lenguaje

Sabemos que no podemos mitigar en su totalidad la incertidumbre pero podemos asociar niveles de confianza a la información, por ejemplo usando probabilidades o factores de certeza. Veamos algunos ejemplos de esto:

Podemos modelar la incertidumbre a través del teorema de Bayes.

*estos datos son ilustrativos

P(S/M)=0,5 Probabilidad de tener Covid y fiebre

P(M)=1/6 Probabilidad de tener Covid

P(S)=1/20 Probabilidad de tener fiebre

P(M/S)=(0,5)*(1/6)/(1/20)=1.6

Como dijimos es muy difícil tener una certeza por que no tenemos todas las variables, además que debemos tener en cuenta las variables excluyentes también, ahí se nos va complicando la cosa.

Otra aproximación puede ser el uso de factores de certeza, estos son básicamente juicios dados por un experto e implementados correctamente puede facilitar muchísimo las estimaciones.

Por ejemplo, con la pandemia si tenias tos y fiebre el valor de certeza de Covid era muy alto, los médicos señalaban casi con total seguridad de que se trataba de este virus.

Los valores de certeza se dan en un intervalo de ![Rendered by QuickLaTeX.com [-1,1]](https://jhontona.com/wp-content/ql-cache/quicklatex.com-b91f34c6ba4ee80f73013b8f66c5760a_l3.png) , donde

, donde  indica completa confianza y

indica completa confianza y  la no creencia. Veamos la definición matemática para calcular un valor de certeza.

la no creencia. Veamos la definición matemática para calcular un valor de certeza.  y

y  son reglas que alcanzan una misma conclusión

son reglas que alcanzan una misma conclusión  , a partir de dos evidencias

, a partir de dos evidencias  y

y  :

:

: Si

: Si  entonces

entonces  , CF(h,e_1)

, CF(h,e_1)

: Si

: Si  entonces

entonces  , CF(h,e_2)

, CF(h,e_2)

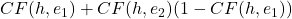

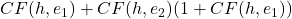

El factor de certeza de  se calcula como:

se calcula como:

, si

, si  y

y

, si

, si  y

y

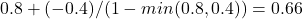

![Rendered by QuickLaTeX.com [CF(h,e_1)+CF(h,e_2)]/(1-min(|CF(h,e_1)|,|CF(h,e_2)|)](https://jhontona.com/wp-content/ql-cache/quicklatex.com-8b2df566acecc30a553de0f721bb3c9c_l3.png) , en cualquier otro caso

, en cualquier otro caso

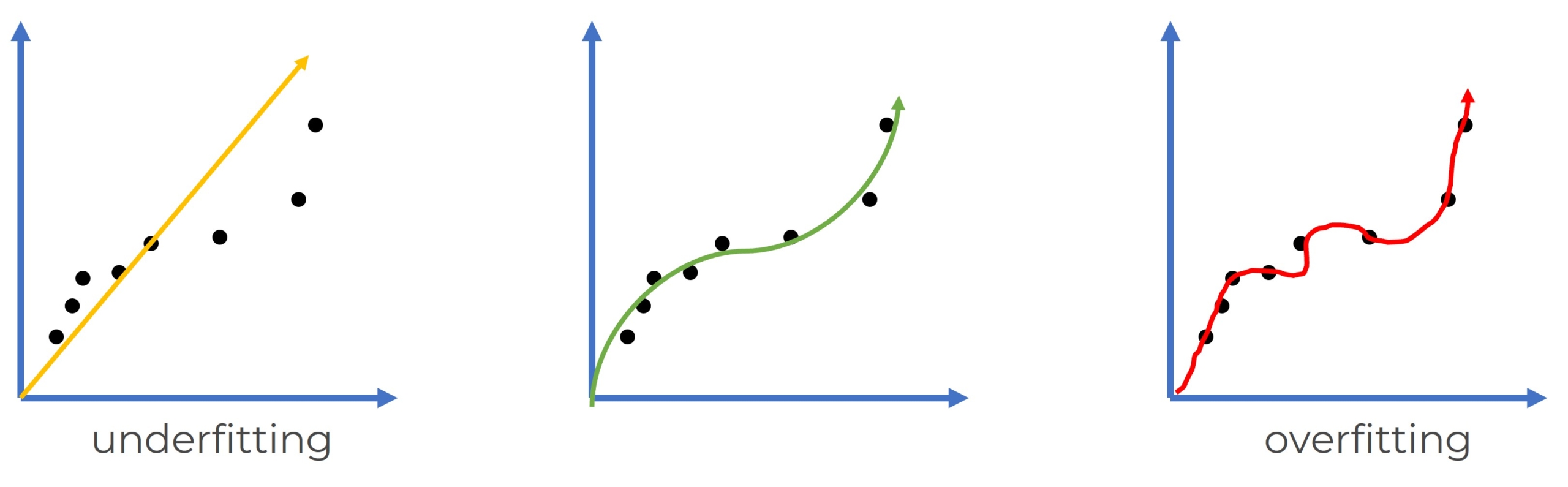

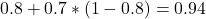

Veamos unos ejemplos:

: Si viernes entonces trafico,

: Si viernes entonces trafico,

: Si llueve entonces trafico,

: Si llueve entonces trafico,

: Hoy es viernes y llueve ¿Cuál es la certeza de trafico?

: Hoy es viernes y llueve ¿Cuál es la certeza de trafico?

*Se refuerza la certeza con ambas positivas

: Si viernes entonces trafico,

: Si viernes entonces trafico,

: Si fin de mes entonces trafico,

: Si fin de mes entonces trafico,

: Hoy es viernes y fin de mes ¿Cuál es la certeza de trafico?

: Hoy es viernes y fin de mes ¿Cuál es la certeza de trafico?

*Se disminuye la fuerza de la mayor